Apple har bestemt seg for å utsette de nye verktøyene som skal detektere overgrepsmateriale på iOS-enheter.

Avgjørelsen kommer etter kritikk fra flere hold. Det har blant annet blitt hevdet at det er fullt mulig å lure systemet, og ikke minst at de nye verktøyene kan brukes for overvåkning av andre ting enn bare overgrepsbilder.

Dette sier Apple nå

«Forrige måned annonserte vi våre planer for funksjoner som har til hensikt å beskytte barn fra overgripere som bruker kommuniksasjonsverktøy for å finne og utnytte dem, og å begrense spredningen av overgrepsmateriale. Basert på tilbakemeldingene fra kunder, interesseorganisasjoner, forskere og andre, har vi bestemt oss for å bruke mer tid iløpet av de kommende månedene på å samle inn tilbakemeldinger og gjøre forbedringer før vi lanserer disse viktige sikkerhetsfunksjonene», sier Apple i en uttalelse.

De nye funksjonene skulle egentlig lanseres sammen med iOS 15, iPadOS 15, watchOS 8 og macOS Monterey.

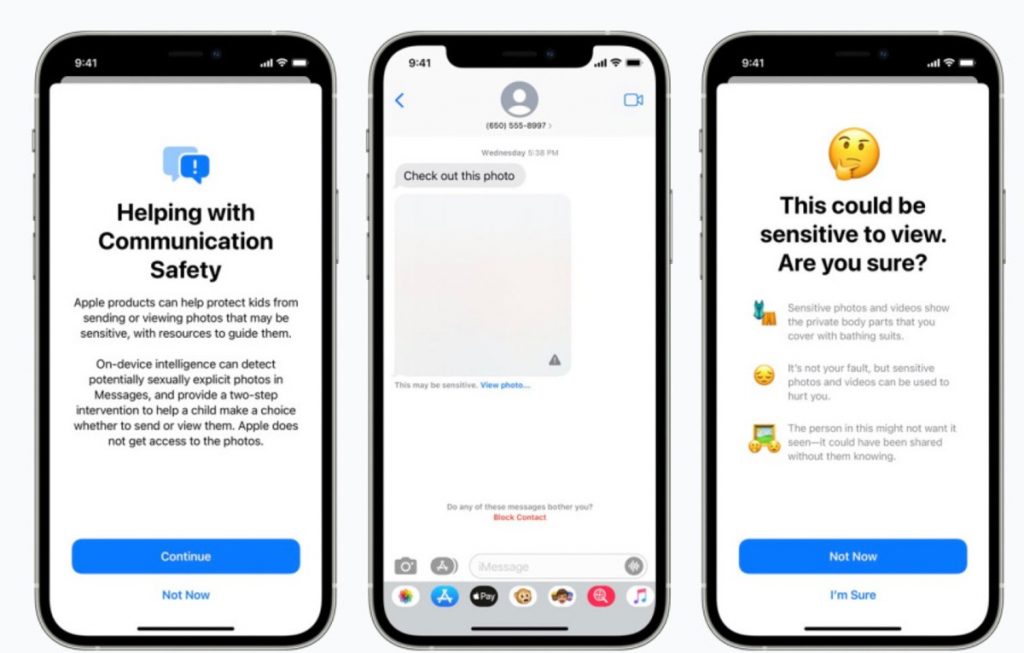

Maskinlæring i iMessage

I tillegg til gjenkjenning av overgrepsbilder i iCloud, skulle en iMessage-funksjon sørge for å varsle barn og deres foreldre når Apple oppdager at seksuelle bilder blir delt i appen. Apples verktøy skal bruke maskinlæring for å identifisere slikt innhold.

Nå blir det altså ingen slik funksjonalitet med det første.

Slik skulle det fungere

Istedenfor å scanne bilder som ligger i skyen, skulle det nye systemet gjøre nødvendige analyser på selve enheten. Apples teknologi skulle matche bilder opp mot en database som tilbys av National Center for Missing and Exploited Children, samt fra andre organisasjoner som jobber for barns sikkerhet. Denne databasen skulle være trygt lagret på brukerens enheter, uten at noen kunne få tilgang til den.

Før en bruker lagrer et bilde i iCloud, skulle en analyse på selve enheten matche bildet opp mot den nevnte databasen. Hvis systemet skulle oppdage ovegrepsmateriale, og et menneskelig gjennomgang bekrefter funnet, ville Apple deaktivert personens konto og sende en rapport til National Center for Missing and Exploited Children.

Forskere kaller teknologien «farlig»

Flere har uttrykt bekymring for at politi eller myndigheter skal kunne presse Apple til å bruke denne teknologien til andre formål, for eksempel å ta politiske aktivister.

To professorer ved Princeton University hevder de har laget et lignende system som Apple, og kaller teknologien for «farlig».

«Vårt system kan enkelt bli brukt til overvåkning og sensur. Systemet er ikke begrenset til en spesifikk kategori av innhold, så en tjeneste kan ganske enkelt bytte ut enhver database uten at personen som bruker tjenesten merker det», skriver forskerne i en kronikk publisert i The Washington Post.

16 kommentarer

Wow, marvelous weblog structure! How long have you been blogging for?

you make running a blog look easy. The full look of your site is wonderful, as neatly as the content!

You can see similar here najlepszy sklep

Appreciation to my father who shared with me about this blog, this webpage is really awesome.

Wow, awesome blog structure! How lengthy have you ever been blogging for?

you made blogging look easy. The whole glance

of your website is great, let alone the content! You can see similar here sklep internetowy

Wow, incredible blog layout! How long have you ever been running a blog for?

you make blogging look easy. The total glance of

your website is excellent, let alone the content material! You can see similar

here sklep internetowy

Hey very nice site!! Guy .. Beautiful .. Superb ..

I’ll bookmark your blog and take the feeds also? I’m satisfied to search out a lot of helpful info here within the publish, we need

work out extra strategies on this regard, thank you for sharing.

. . . . . I saw similar here: Najlepszy sklep

Wow, marvelous weblog layout! How lengthy have you ever been blogging for?

you make running a blog look easy. The entire glance of your

site is fantastic, let alone the content material! You can see

similar here e-commerce

Your article helped me a lot, is there any more related content? Thanks!

Howdy! Do you know if they make any plugins to assist with SEO?

I’m trying to get my blog to rank for some targeted keywords but I’m not

seeing very good results. If you know of any please share.

Many thanks! You can read similar art here: Sklep

It’s very interesting! If you need help, look here: ARA Agency

Hello there! Do you know if they make any plugins to help with SEO?

I’m trying to get my blog to rank for some targeted keywords but I’m not seeing very good results.

If you know of any please share. Kudos! You can read similar article here: E-commerce

Good day! Do you know if they make any plugins to assist with SEO?

I’m trying to get my blog to rank for some targeted keywords but I’m not

seeing very good success. If you know of any please share.

Many thanks! You can read similar art here: Backlinks List

Hi there! Do you know if they make any plugins to help with SEO?

I’m trying to get my blog to rank for some targeted keywords but I’m not seeing very good results.

If you know of any please share. Many thanks! I saw similar art here: Hitman.agency

Good day! Do you know if they make any plugins to help with

Search Engine Optimization? I’m trying to get my website to rank for some targeted keywords but I’m not seeing very good success.

If you know of any please share. Thanks! I saw similar art here:

Backlink Building

Wow, superb blog layout! How long have you been blogging for? you make blogging look easy. The overall look of your site is great, let alone the content!

Hello there, simply was aware of your blog through Google, and found that it is really informative. I’m gonna watch out for brussels. I will appreciate for those who continue this in future. Lots of other folks will be benefited from your writing. Cheers!

Wow, awesome blog layout! How long have you ever been running

a blog for? you made blogging look easy. The full glance of your site is fantastic, as well as the content material!

You can see similar here najlepszy sklep